Pustaka 'set data' daripada Hugging Face menyediakan cara yang mudah untuk bekerja dengan dan memanipulasi set data untuk tugas pemprosesan bahasa semula jadi. Satu fungsi berguna yang ditawarkan oleh pustaka ialah concatenate_datasets() yang membolehkan anda menggabungkan berbilang set data ke dalam set data tunggal. Berikut ialah gambaran keseluruhan ringkas fungsi concatenate_datasets() dan cara menggunakannya.

concatenate_datasets()

Penerangan:

Pustaka 'set data' Memeluk Wajah menyediakan fungsi concatenate_datasets(). Ia digunakan untuk menggabungkan berbilang set data, menggabungkannya menjadi set data tunggal di sepanjang paksi yang ditentukan. Fungsi ini amat berguna apabila anda mempunyai berbilang set data yang berkongsi struktur yang sama dan anda ingin menggabungkannya menjadi set data bersatu untuk pemprosesan dan analisis selanjutnya.

Sintaks:

daripada set data import concatenate_datasets

set data bercantum = concatenate_datasets ( set data , paksi = 0 , info = tiada )

Parameter:

set data (senarai Set Data): Senarai set data yang ingin anda gabungkan. Set data ini harus mempunyai ciri yang serasi yang bermaksud bahawa ia mempunyai skema, nama lajur dan jenis data yang sama.

paksi (int, pilihan, lalai=0): Paksi sepanjang penggabungan harus dilakukan. Untuk kebanyakan set data NLP, nilai lalai 0 digunakan yang bermaksud set data digabungkan secara menegak. Jika anda menetapkan paksi=1, set data disatukan secara mendatar, dengan mengandaikan bahawa ia mempunyai lajur yang berbeza sebagai ciri.

info (datasets.DatasetInfo, pilihan): Maklumat tentang set data yang digabungkan. Jika tidak diberikan, maklumat disimpulkan daripada set data pertama dalam senarai.

Pulangan:

set data bercantum (Dataset): Set data yang terhasil selepas menggabungkan semua set data input.

Contoh:

# Langkah 1: Pasang pustaka set data# Anda boleh memasangnya menggunakan pip:

# !pip memasang set data

# Langkah 2: Import perpustakaan yang diperlukan

daripada set data import set_data_muat , concatenate_datasets

# Langkah 3: Muatkan set data semakan filem IMDb

# Kami akan menggunakan dua set data IMDb, satu untuk ulasan positif

#dan satu lagi untuk ulasan negatif.

# Muatkan 2500 ulasan positif

dataset_pos = set_data_muat ( 'imdb' , berpecah = 'kereta api[:2500]' )

# Muatkan 2500 ulasan negatif

dataset_neg = set_data_muat ( 'imdb' , berpecah = 'kereta api[-2500:]' )

# Langkah 4: Menggabungkan set data

# Kami menggabungkan kedua-dua set data sepanjang paksi=0, seperti yang ada

skema yang sama ( ciri yang sama ) .

set data bercantum = concatenate_datasets ( [ dataset_pos , dataset_neg ] )

# Langkah 5: Analisis set data yang digabungkan

# Untuk kesederhanaan, mari kita mengira bilangan positif dan negatif

# ulasan dalam set data yang digabungkan.

num_positive_reviews = jumlah ( 1 untuk label dalam

set data bercantum [ 'label' ] jika label == 1 )

num_negative_reviews = jumlah ( 1 untuk label dalam

set data bercantum [ 'label' ] jika label == 0 )

# Langkah 6: Paparkan keputusan

cetak ( 'Bilangan ulasan positif:' , num_positive_reviews )

cetak ( 'Bilangan ulasan negatif:' , num_negative_reviews )

# Langkah 7: Cetak beberapa contoh ulasan daripada set data yang digabungkan

cetak ( ' \n Beberapa contoh ulasan:' )

untuk i dalam julat ( 5 ) :

cetak ( f 'Semak {i + 1}: {concatenated_dataset['text'][i]}' )

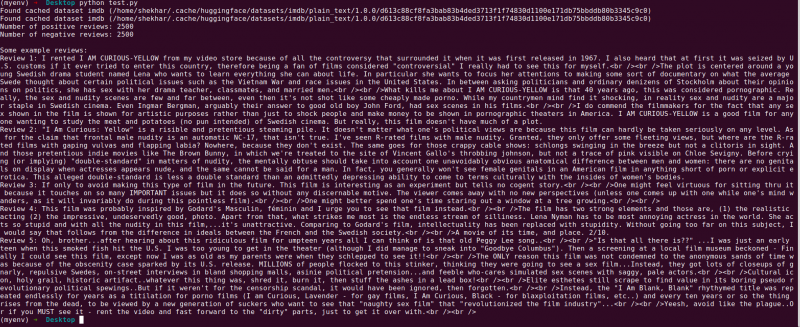

Pengeluaran:

Berikut ialah penjelasan untuk program perpustakaan 'set data' Hugging Face yang menggabungkan dua set data semakan filem IMDb. Ini menerangkan tujuan program, penggunaannya, dan langkah-langkah yang terlibat dalam kod.

Mari berikan penjelasan yang lebih terperinci tentang setiap langkah dalam kod:

# Langkah 1: Import Perpustakaan Diperlukandaripada set data import set_data_muat , concatenate_datasets

Dalam langkah ini, kami mengimport perpustakaan yang diperlukan untuk program ini. Kami memerlukan fungsi 'load_dataset' untuk memuatkan set data semakan filem IMDb dan 'concatenate_datasets' untuk menggabungkannya kemudian.

# Langkah 2: Muatkan Set Data Semakan Filem IMDb# Muatkan 2500 ulasan positif

dataset_pos = set_data_muat ( 'imdb' , berpecah = 'kereta api[:2500]' )

# Muatkan 2500 ulasan negatif

dataset_neg = set_data_muat ( 'imdb' , berpecah = 'kereta api[-2500:]' )

Di sini, kami menggunakan fungsi 'load_dataset' untuk mengambil dua subset set data IMDb. 'dataset_pos' memegang 2500 ulasan positif dan 'dataset_neg' mengandungi 2500 ulasan negatif. Kami menggunakan parameter pisah untuk menentukan julat contoh untuk dimuatkan yang membolehkan kami memilih subset daripada keseluruhan set data.

# Langkah 3: Gabungkan Set Dataset data bercantum = concatenate_datasets ( [ dataset_pos , dataset_neg ] )

Dalam langkah ini, kami menggabungkan dua subset set data IMDb ke dalam set data tunggal yang dipanggil 'concatenated_dataset'. Kami menggunakan fungsi 'concatenate_datasets' dan menyampaikannya dengan senarai yang mengandungi dua set data untuk digabungkan. Memandangkan kedua-dua set data mempunyai ciri yang sama, kami menggabungkannya sepanjang axis=0 yang bermaksud bahawa baris disusun di atas satu sama lain.

# Langkah 4: Analisis Set Data Bercantumnum_positive_reviews = jumlah ( 1 untuk label dalam

set data bercantum [ 'label' ] jika label == 1 )

num_negative_reviews = jumlah ( 1 untuk label dalam

set data bercantum [ 'label' ] jika label == 0 )

Di sini, kami melakukan analisis ringkas bagi set data yang digabungkan. Kami menggunakan pemahaman senarai bersama-sama dengan fungsi 'jumlah' untuk mengira bilangan ulasan positif dan negatif. Kami berulang melalui “ label' lajur 'set_data bercantum' dan tambahkan kiraan apabila kami menemui label positif (1) atau label negatif (0).

# Langkah 5: Paparkan Keputusancetak ( 'Bilangan ulasan positif:' , num_positive_reviews )

cetak ( 'Bilangan ulasan negatif:' , num_negative_reviews )

Dalam langkah ini, kami mencetak hasil analisis kami - bilangan ulasan positif dan negatif dalam set data yang digabungkan.

# Langkah 6: Cetak Beberapa Contoh Ulasancetak ( ' \n Beberapa contoh ulasan:' )

untuk i dalam julat ( 5 ) :

cetak ( f 'Semak {i + 1}: {concatenated_dataset['text'][i]}' )

Akhir sekali, kami mempamerkan beberapa contoh ulasan daripada set data yang digabungkan. Kami mengulangi lima contoh pertama dalam set data dan mencetak kandungan teksnya menggunakan lajur 'teks'.

Kod ini menunjukkan contoh mudah menggunakan perpustakaan 'set data' Hugging Face untuk memuatkan, menggabungkan dan menganalisis set data semakan filem IMDb. Ia menyerlahkan keupayaan perpustakaan untuk menyelaraskan pengendalian set data NLP dan mempamerkan potensinya untuk membina model dan aplikasi pemprosesan bahasa semula jadi yang lebih canggih.

Kesimpulan

Program Python yang menggunakan perpustakaan 'set data' Hugging Face berjaya menunjukkan gabungan dua set data semakan filem IMDb. Dengan memuatkan subset ulasan positif dan negatif, program ini menggabungkannya menjadi satu set data menggunakan fungsi concatenate_datasets(). Ia kemudian melakukan analisis mudah dengan mengira bilangan ulasan positif dan negatif dalam set data gabungan.

Pustaka 'set data' memudahkan proses pengendalian dan memanipulasi set data NLP, menjadikannya alat yang berkuasa untuk penyelidik, pembangun dan pengamal NLP. Dengan antara muka mesra pengguna dan fungsi yang luas, perpustakaan membolehkan prapemprosesan, penerokaan dan transformasi data yang mudah. Program yang dipamerkan dalam dokumentasi ini berfungsi sebagai contoh praktikal bagaimana perpustakaan boleh dimanfaatkan untuk menyelaraskan tugas penggabungan dan analisis data.

Dalam senario kehidupan sebenar, program ini boleh berfungsi sebagai asas untuk tugas pemprosesan bahasa semula jadi yang lebih kompleks seperti analisis sentimen, klasifikasi teks dan pemodelan bahasa. Menggunakan perpustakaan 'set data', penyelidik dan pembangun boleh mengurus set data berskala besar dengan cekap, memudahkan percubaan dan mempercepatkan pembangunan model NLP tercanggih. Secara keseluruhannya, perpustakaan 'set data' Hugging Face berdiri sebagai aset penting dalam mengejar kemajuan dalam pemprosesan dan pemahaman bahasa semula jadi.