Entri data individu disimpan dalam bentuk ' Tensor ” dalam PyTorch dan “ kecerunan ” tensor dikira menggunakan perambatan ke belakang dalam gelung latihan model pembelajaran mendalam. istilah “ tidak berskala ” bermakna data adalah mentah dan tiada prapemprosesan atau pengoptimuman yang terlibat. Kecerunan tidak berskala Tensor memberikan nilai sebenar perubahan tentang fungsi kehilangan yang ditentukan.

Dalam blog ini, kita akan membincangkan cara mengira kecerunan tidak berskala Tensor dalam PyTorch.

Apakah Kecerunan Tidak Berskala Tensor dalam PyTorch?

Tensor ialah tatasusunan berbilang dimensi yang mengandungi data dan boleh dijalankan pada GPU dalam PyTorch. Tensor yang mengandungi data mentah daripada set data tanpa sebarang prapemprosesan, transformasi atau pengoptimuman dipanggil tensor tidak berskala. Walau bagaimanapun, ' Kecerunan Tidak Berskala ” adalah berbeza daripada tensor tidak berskala dan penjagaan mesti diambil untuk tidak mengelirukan kedua-duanya. Kecerunan tidak berskala tensor dikira berkenaan dengan fungsi kehilangan yang dipilih dan ia tidak mempunyai sebarang pengoptimuman atau penskalaan selanjutnya.

Bagaimana untuk Mengira Kecerunan Tidak Berskala Tensor dalam PyTorch?

Kecerunan tidak berskala Tensor ialah nilai sebenar kadar perubahan data input berkaitan fungsi kehilangan yang dipilih. Data kecerunan mentah adalah penting untuk memahami kelakuan model dan perkembangannya semasa gelung latihan.

Ikuti langkah yang diberikan di bawah untuk mengetahui cara mengira kecerunan tidak berskala tensor dalam PyTorch:

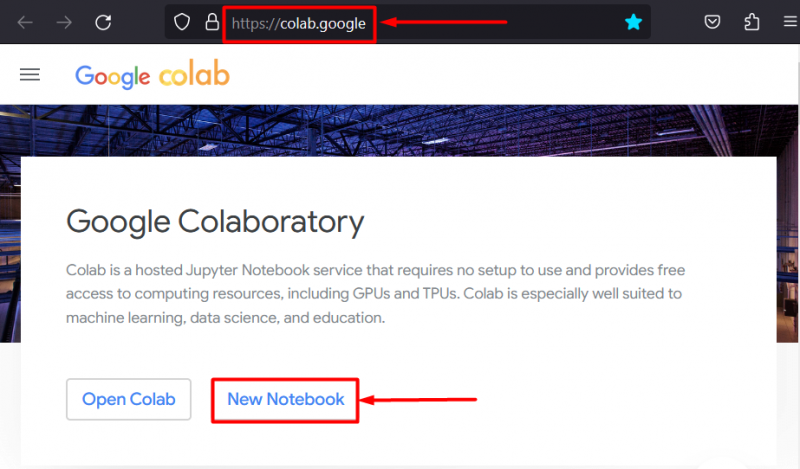

Langkah 1: Mulakan Projek dengan menyediakan IDE

Google Colaboratory IDE ialah salah satu pilihan terbaik untuk pembangunan projek PyTorch kerana ia menyediakan akses percuma kepada GPU untuk pemprosesan yang lebih pantas. Pergi ke Colab laman web dan klik pada “ Buku Nota Baharu ” pilihan untuk mula bekerja:

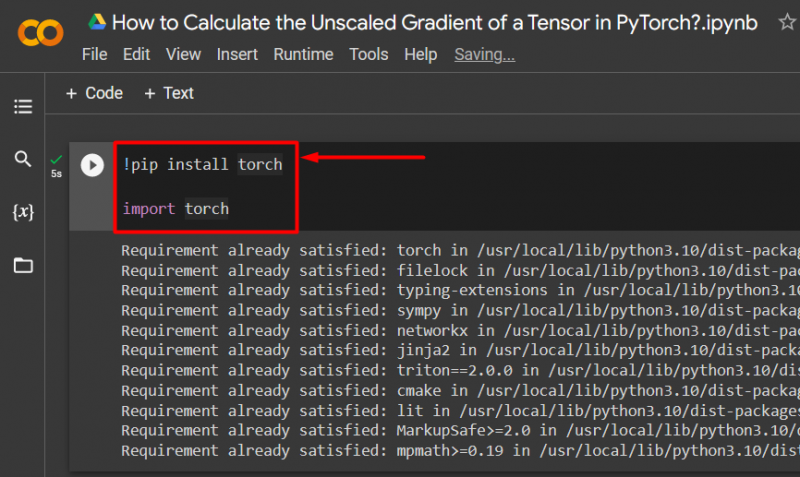

Langkah 2: Import Pustaka Obor Penting

Semua fungsi rangka kerja PyTorch terkandung dalam ' obor ” perpustakaan. Setiap projek PyTorch bermula dengan memasang dan mengimport perpustakaan ini:

!pip pasang oborobor import

Kod di atas berfungsi seperti berikut:

- “! pip ” ialah pakej pemasangan untuk Python yang digunakan untuk memasang perpustakaan dalam projek.

- ' import Perintah ” digunakan untuk memanggil perpustakaan yang dipasang ke dalam projek.

- Projek ini hanya memerlukan fungsi ' obor ” perpustakaan:

Langkah 3: Tentukan Tensor PyTorch dengan Gradien

Menggunakan ' obor.tensor ()' kaedah untuk menentukan tensor dengan kecerunan ' require_grad=Benar ' kaedah:

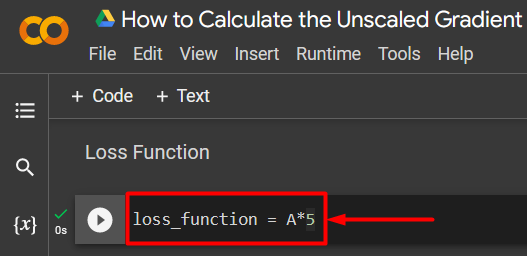

A = torch.tensor([5.0], require_grad=True)Langkah 4: Tentukan Fungsi Kehilangan Mudah

Fungsi kehilangan ditakrifkan menggunakan persamaan aritmetik mudah seperti yang ditunjukkan:

fungsi_kehilangan = A*5

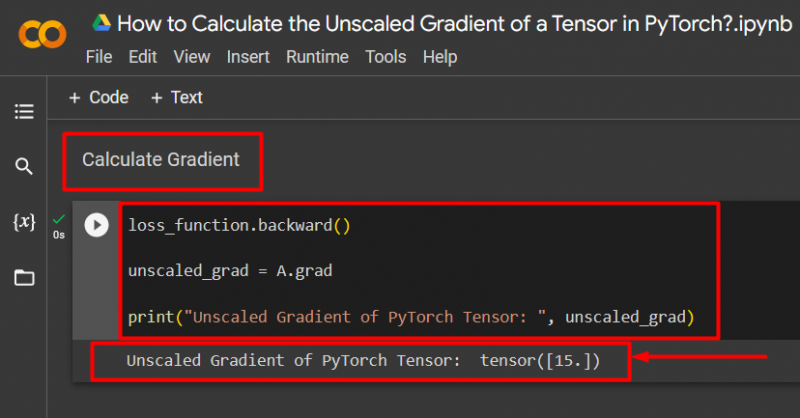

Langkah 5: Kira Gradien dan Cetak ke Output

Menggunakan ' ke belakang ()” kaedah untuk mengira kecerunan tidak berskala seperti yang ditunjukkan:

loss_function.backward()unscaled_grad = A.grad

print('Kecerunan Tidak Berskala Tensor PyTorch: ', tidak berskala_grad)

Kod di atas berfungsi seperti berikut:

- Menggunakan ' ke belakang ()” kaedah untuk mengira kecerunan tidak berskala melalui perambatan ke belakang.

- Tetapkan ' A.grad ' kepada ' unscaled_grad ” pembolehubah.

- Akhir sekali, gunakan ' cetak ()” kaedah untuk mempamerkan output kecerunan tidak berskala:

Catatan : Anda boleh mengakses Buku Nota Colab kami di sini pautan .

Petua Pro

Kecerunan tensor yang tidak berskala boleh menunjukkan hubungan tepat data input dengan fungsi kehilangan untuk rangkaian saraf dalam rangka kerja PyTorch. Kecerunan mentah yang belum diedit menunjukkan cara kedua-dua nilai berkaitan secara sistematik.

Berjaya! Kami baru sahaja menunjukkan cara mengira kecerunan tidak berskala tensor dalam PyTorch.

Kesimpulan

Kira kecerunan tidak berskala tensor dalam PyTorch dengan terlebih dahulu mentakrifkan tensor, dan kemudian menggunakan kaedah ke belakang() untuk mencari kecerunan. Ini menunjukkan cara model pembelajaran mendalam mengaitkan data input dengan fungsi kehilangan yang ditentukan. Dalam blog ini, kami telah memberikan tutorial langkah-bijak tentang cara mengira kecerunan tidak berskala tensor dalam PyTorch.