Siaran ini menggambarkan kaedah menggunakan fungsi dan kelas penghurai output melalui rangka kerja LangChain.

Bagaimana untuk Menggunakan Penghurai Output Melalui LangChain?

Penghurai output ialah output dan kelas yang boleh membantu untuk mendapatkan output berstruktur daripada model. Untuk mempelajari proses menggunakan penghurai keluaran dalam LangChain, hanya melalui langkah-langkah yang disenaraikan:

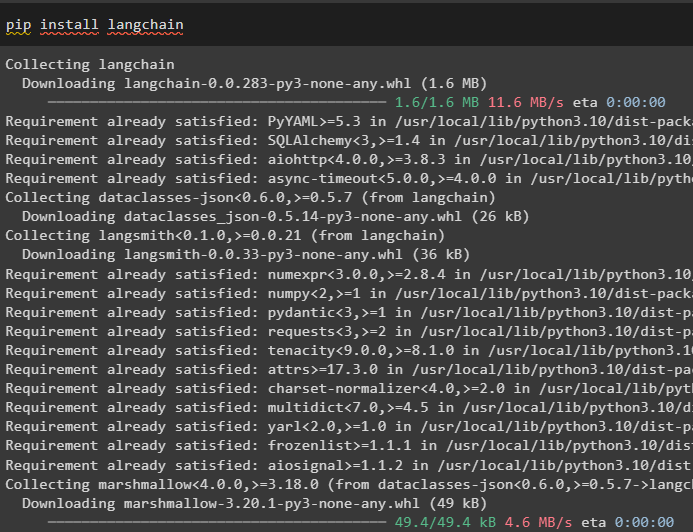

Langkah 1: Pasang Modul

Mula-mula, mulakan proses menggunakan penghurai keluaran dengan memasang modul LangChain dengan kebergantungannya untuk melalui proses:

pip pasang langchain

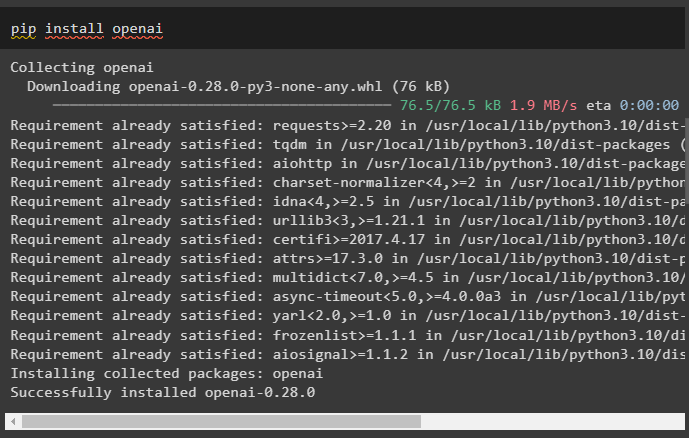

Selepas itu, pasang modul OpenAI untuk menggunakan perpustakaannya seperti OpenAI dan ChatOpenAI:

pip pasang openai

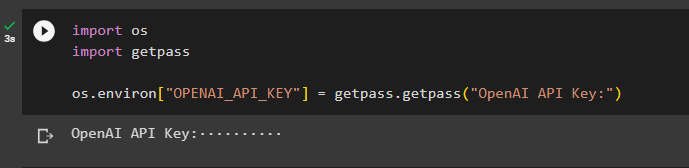

Sekarang, sediakan persekitaran untuk OpenAI menggunakan kunci API daripada akaun OpenAI:

import kami

import getpass

os.environ [ 'OPENAI_API_KEY' ] = getpass.getpass ( 'OpenAI API Key:' )

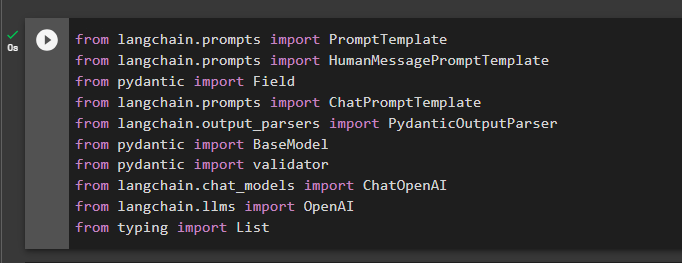

Langkah 2: Import Perpustakaan

Langkah seterusnya ialah mengimport perpustakaan dari LangChain untuk menggunakan penghurai output dalam rangka kerja:

daripada langchain.prompts import HumanMessagePromptTemplate

daripada Medan import pydantic

daripada langchain.prompts import ChatPromptTemplate

daripada langchain.output_parsers import PydanticOutputParser

daripada BaseModel import pydantic

daripada pengesah import pydantic

daripada langchain.chat_models import ChatOpenAI

daripada langchain.llms import OpenAI

daripada menaip Senarai import

Langkah 3: Membina Struktur Data

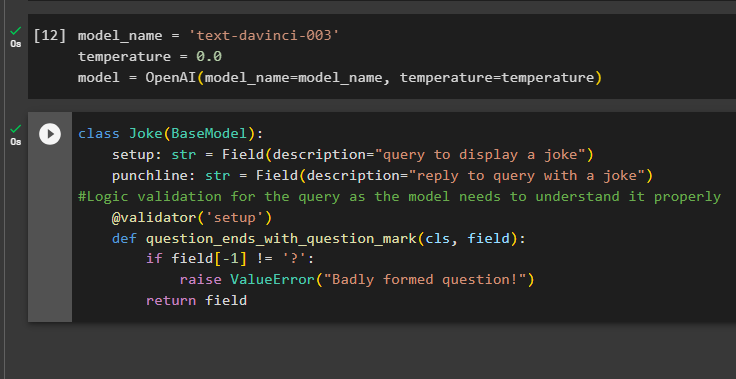

Membina struktur output adalah aplikasi penting penghurai output dalam Model Bahasa Besar. Sebelum sampai ke struktur data model, anda perlu menentukan nama model yang kami gunakan untuk mendapatkan output berstruktur daripada penghurai output:

suhu = 0.0

model = OpenAI ( nama model =nama_model, suhu =suhu )

Sekarang, gunakan kelas Jenaka yang mengandungi BaseModel untuk mengkonfigurasi struktur output untuk mendapatkan jenaka daripada model. Selepas itu, pengguna boleh menambah logik pengesahan tersuai dengan mudah dengan kelas pydantic yang boleh meminta pengguna untuk meletakkan pertanyaan/prompt yang lebih baik:

Jenaka kelas ( BaseModel ) :persediaan: str = Medan ( penerangan = 'pertanyaan untuk memaparkan jenaka' )

punchline: str = Medan ( penerangan = 'balas pertanyaan dengan jenaka' )

#Pengesahan logik untuk pertanyaan kerana model perlu memahaminya dengan betul

@ pengesah ( 'setup' )

def question_ends_with_question_mark ( cls, medan ) :

jika padang [ - 1 ] ! = '?' :

meningkatkan ValueError ( 'Soalan yang terbentuk teruk!' )

kembali padang

Langkah 4: Tetapkan Templat Prompt

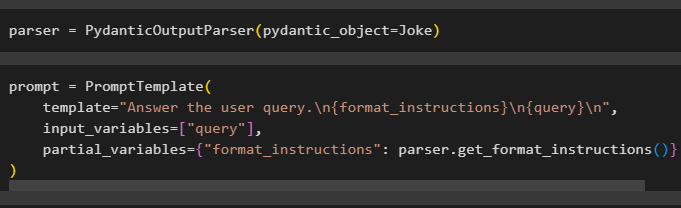

Konfigurasikan pembolehubah parser yang mengandungi kaedah PydanticOutputParser() yang mengandungi parameternya:

Selepas mengkonfigurasi parser, hanya tentukan pembolehubah segera menggunakan kaedah PromptTemplate() dengan struktur pertanyaan/prompt:

gesaan = PromptTemplate (templat = 'Jawab pertanyaan pengguna. \n {format_instructions} \n {query} \n ' ,

input_variables = [ 'pertanyaan' ] ,

pembolehubah_separa = { 'format_arahan' : parser.get_format_instructions ( ) }

)

Langkah 5: Uji Penghurai Output

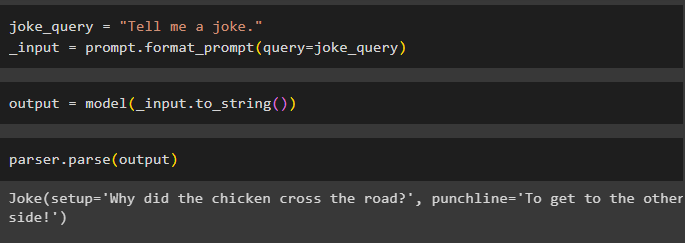

Selepas mengkonfigurasi semua keperluan, buat pembolehubah yang ditetapkan menggunakan pertanyaan dan kemudian panggil kaedah format_prompt() :

_input = prompt.format_prompt ( pertanyaan =pertanyaan_lawak )

Sekarang, panggil fungsi model() untuk menentukan pembolehubah output:

keluaran = model ( _input.to_string ( ) )Lengkapkan proses ujian dengan memanggil kaedah parser() dengan pembolehubah output sebagai parameternya:

parser.parse ( pengeluaran )

Itu semua tentang proses menggunakan penghurai output dalam LangChain.

Kesimpulan

Untuk menggunakan penghurai output dalam LangChain, pasang modul dan sediakan persekitaran OpenAI menggunakan kunci APInya. Selepas itu, tentukan model dan kemudian konfigurasikan struktur data output dengan pengesahan logik pertanyaan yang disediakan oleh pengguna. Setelah struktur data dikonfigurasikan, hanya tetapkan templat segera, dan kemudian uji penghurai output untuk mendapatkan hasil daripada model. Panduan ini telah menggambarkan proses menggunakan penghurai output dalam rangka kerja LangChain.