Siaran ini akan menggambarkan proses membina aplikasi LangChain menggunakan Prompt Template dan Output Parser.

Bagaimana untuk Membina Aplikasi LangChain Menggunakan Templat Prompt dan Penghurai Output?

Untuk membina aplikasi LangChain menggunakan templat segera dan penghurai keluaran, hanya melalui panduan mudah ini:

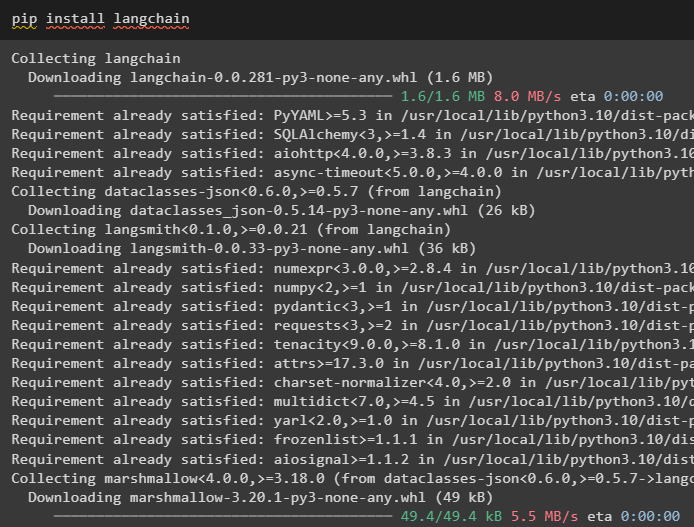

Langkah 1: Pasang LangChain

Mula-mula, mulakan proses membina aplikasi LangChain dengan memasang rangka kerja LangChain menggunakan “ pip ” perintah:

pip pasang langchain

Langkah 2: Menggunakan Templat Prompt

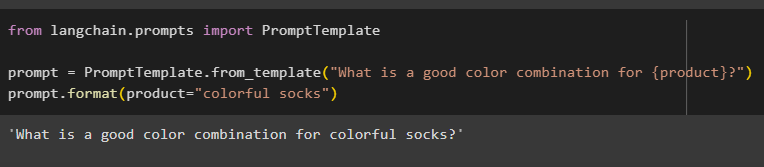

Selepas memasang modul LangChain, import “ PromptTemplate ” untuk membina templat segera dengan menyediakan pertanyaan untuk model memahami soalan:

daripada langchain.prompts import PromptTemplate

prompt = PromptTemplate.from_template('Apakah kombinasi warna yang baik untuk {produk}?')

prompt.format(product='stokin berwarna-warni')

Output secara automatik menggabungkan ayat dengan nilai ' produk ” pembolehubah:

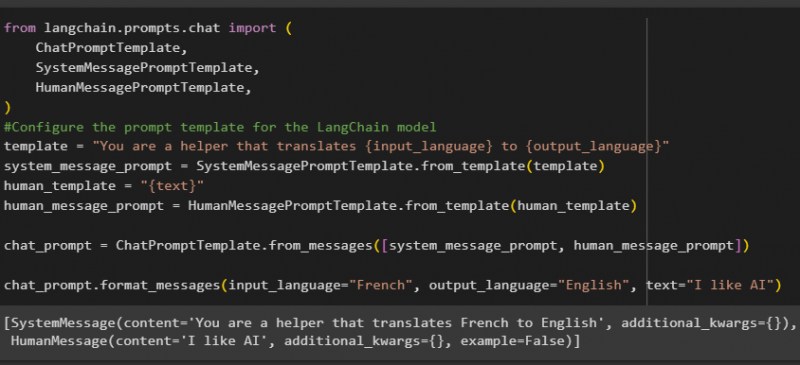

Selepas itu, bina templat gesaan lain dengan mengimport pustaka HumanMessagePromptTemplate, ChatPromptTemplate dan SystemMessagePromptTemplate daripada LangChain:

daripada langchain.prompts.chat import (ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Konfigurasikan templat segera untuk model LangChain

template = 'Anda ialah pembantu yang menterjemah {input_language} kepada {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(template)

human_template = '{teks}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='Perancis', output_language='Inggeris', text='Saya suka AI')

Selepas mengimport semua perpustakaan yang diperlukan, hanya bina templat tersuai untuk pertanyaan menggunakan pembolehubah templat:

Templat gesaan hanya digunakan untuk menetapkan templat untuk pertanyaan/soalan dan ia tidak membalas dengan sebarang jawapan kepada soalan itu. Walau bagaimanapun, fungsi OutputParser() boleh mengekstrak jawapan seperti yang dijelaskan oleh bahagian berikut dengan contoh:

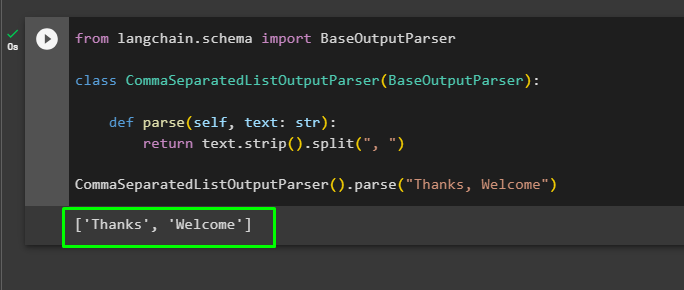

Langkah 3: Menggunakan Penghurai Output

Sekarang, import pustaka BaseOutputParser dari LangChain untuk memisahkan nilai teks yang dipisahkan dengan koma dan mengembalikan senarai dalam output:

daripada langchain.schema import BaseOutputParserkelas CommaSeparatedListOutputParser(BaseOutputParser):

def parse(self, text: str):

kembalikan text.strip().split(', ')

CommaSeparatedListOutputParser().parse('Terima Kasih, Selamat Datang')

Itu semua tentang membina aplikasi LangChain menggunakan templat segera dan penghurai output.

Kesimpulan

Untuk membina aplikasi LangChain menggunakan templat segera dan penghurai output, cuma pasang LangChain dan import perpustakaan daripadanya. Pustaka PromptTemplate digunakan untuk membina struktur untuk pertanyaan supaya model boleh memahami soalan sebelum mengekstrak maklumat menggunakan fungsi Parser(). Fungsi OutputParser() digunakan untuk mengambil jawapan berdasarkan pertanyaan yang disesuaikan sebelum ini. Panduan ini telah menerangkan proses membina aplikasi LangChain menggunakan templat segera dan penghurai output.